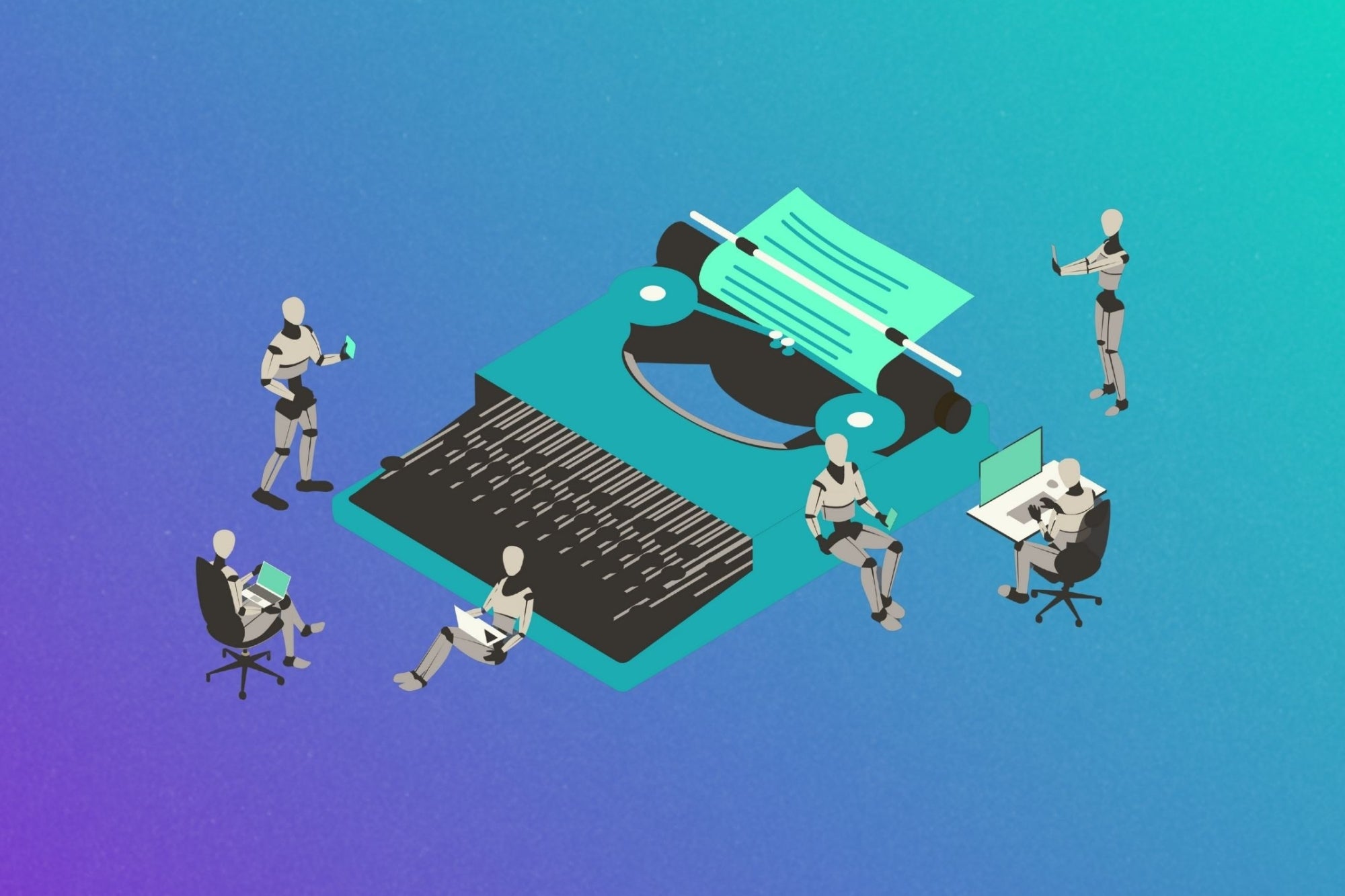

OpenAI Face à un Dilemme : Alerter la Police ?

Les descriptions de la violence armée par Jesse Van Rootselaar ont été signalées par des outils qui surveillent l'utilisation abusive de ChatGPT. Cette situation soulève des questions importantes sur la façon dont les algorithmes interprètent et gèrent des sujets sensibles comme la violence. Dans un monde où les discours autour des armes à feu et de la sécurité publique sont plus que jamais d'actualité, il devient crucial de réfléchir à la manière dont ces conversations sont encadrées et régulées.

La violence armée n'est pas qu'un simple sujet de discussion; c'est une réalité vécue par de nombreuses personnes. Que ce soit à travers des récits personnels ou des statistiques frappantes, il est essentiel d'aborder cette thématique avec nuance et sensibilité. Les outils d'intelligence artificielle, comme ChatGPT, ont le potentiel d'ouvrir des dialogues sur ces enjeux, mais ils doivent aussi être capables de reconnaître quand un contenu pourrait être problématique ou nuisible.

En ce sens, le signalement des descriptions de Van Rootselaar est un rappel que même les meilleures intentions peuvent parfois mener à des malentendus. Les développeurs et les chercheurs doivent continuer à affiner ces systèmes pour qu'ils puissent distinguer entre un discours informatif et une incitation à la violence. La clé réside dans l'éducation et la sensibilisation, tant pour les utilisateurs que pour les concepteurs de technologies.

Pour conclure, alors que nous naviguons dans ce paysage complexe, il est impératif de favoriser des discussions éclairées et respectueuses autour de la violence armée. Chaque voix compte, et les outils que nous utilisons pour communiquer doivent refléter cette diversité d'opinions tout en veillant à la sécurité de tous. L'avenir de nos dialogues dépend de notre capacité à apprendre et à évoluer ensemble.

Quelle est votre réaction ?

Aimer

0

Aimer

0

Je n'aime pas

0

Je n'aime pas

0

Amour

0

Amour

0

Drôle

0

Drôle

0

En colère

0

En colère

0

Triste

0

Triste

0

Waouh

0

Waouh

0