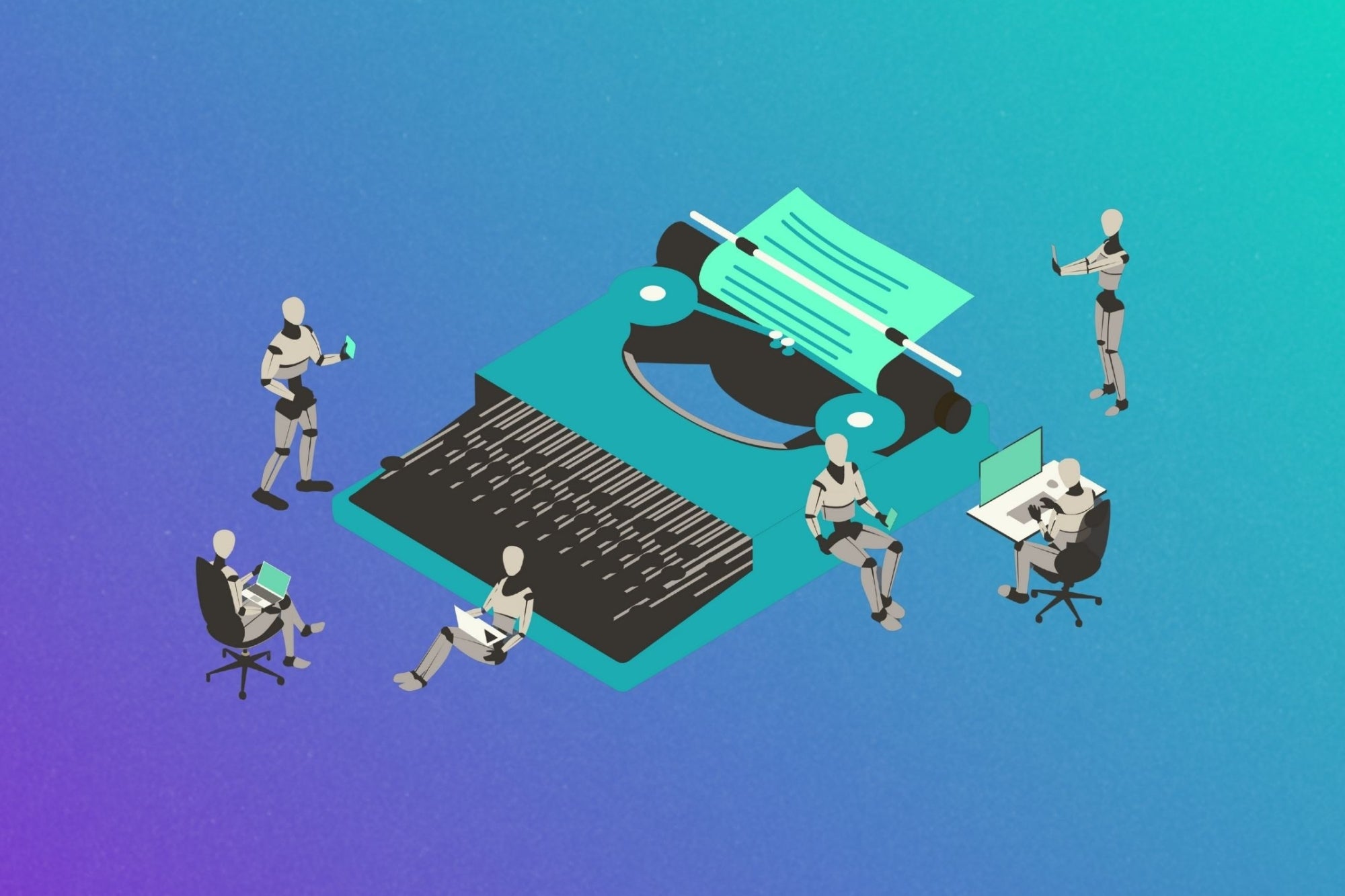

Anthropic et le Pentagone : Clash sur l'utilisation de Claude

La question qui se pose actuellement est la suivante : Claude peut-il être utilisé pour la surveillance de masse au pays et pour des armes autonomes ? Cette inquiétude soulève des débats passionnés sur les limites éthiques et les implications sociétales de l'intelligence artificielle.

À l'heure où la technologie progresse à une vitesse fulgurante, il est essentiel de se demander comment ces avancées peuvent être détournées à des fins néfastes. L'utilisation de systèmes comme Claude pour surveiller les citoyens pourrait poser des risques considérables pour la vie privée et les libertés individuelles. Les Québécois, comme beaucoup d'autres, cherchent à protéger leurs droits fondamentaux tout en profitant des bénéfices que la technologie peut apporter.

De plus, l'idée d'employer une IA pour contrôler des armes autonomes soulève des questions éthiques déchirantes. Qui sera responsable si une telle arme commet une erreur fatale ? Les implications de la délégation de la prise de décision à une machine sont vastes et complexes. Nous devons réfléchir aux conséquences de telles technologies, non seulement sur le plan militaire, mais aussi sur celui de la sécurité publique.

Il est crucial que la communauté, les gouvernements et les chercheurs collaborent pour établir des régulations claires et des lignes directrices éthiques concernant l'utilisation de l'intelligence artificielle dans ces contextes. Nous avons l'occasion de façonner l'avenir de la technologie en veillant à ce qu'elle serve l'humanité et non l'inverse. La vigilance et le dialogue sont essentiels pour naviguer dans cette ère numérique en pleine évolution.

Quelle est votre réaction ?

Aimer

0

Aimer

0

Je n'aime pas

0

Je n'aime pas

0

Amour

0

Amour

0

Drôle

0

Drôle

0

En colère

0

En colère

0

Triste

0

Triste

0

Waouh

0

Waouh

0